零基础学python爬虫(新手Python爬虫入门)

Python爬虫技术在当今数据驱动的世界中变得愈发重要,对于零基础的学习者来说,掌握这项技能不仅能提高数据处理效率,还能为职业发展增添亮点。本文将系统介绍如何从零开始学习Python爬虫,涵盖基础知识、工具选择、实战技巧等方面,帮助初学者快速入门并逐步提升。

文章大纲:

一、Python爬虫基础概述

二、环境搭建与工具准备

三、HTTP协议与网页结构理解

四、Requests库与BeautifulSoup库的使用

五、Selenium库的应用

六、数据存储与处理

七、实战案例分析

八、总结与展望

一、Python爬虫基础概述

Python爬虫是一种自动化脚本,用于模拟人类浏览网页的行为,提取网页中的有价值信息。它广泛应用于数据分析、市场调研、内容聚合等领域。对于零基础的学习者而言,了解爬虫的基本概念和工作原理是首要任务。

二、环境搭建与工具准备

开始学习之前,首先需要搭建Python开发环境。推荐使用Anaconda或直接安装Python官方版本,并配置好虚拟环境。此外,选择合适的IDE(如PyCharm、VS Code)能提高编码效率。常用的第三方库包括Requests(用于发送HTTP请求)、BeautifulSoup(用于解析HTML文档)和Selenium(用于模拟浏览器行为)。

三、HTTP协议与网页结构理解

深入理解HTTP协议和网页结构是编写有效爬虫的基础。HTTP协议定义了客户端和服务器之间的通信规则,而网页通常由HTML、CSS和JavaScript构成。通过掌握这些知识,可以更好地定位和提取所需数据。

四、Requests库与BeautifulSoup库的使用

Requests库简化了HTTP请求的过程,使得获取网页内容变得轻松。结合BeautifulSoup库,可以轻松解析HTML文档,提取所需的文本、链接、图片等信息。例如,使用Requests获取网页内容后,可以通过BeautifulSoup的find()或select()方法精确定位数据。

五、Selenium库的应用

对于动态加载的网页,传统的Requests+BeautifulSoup组合可能无法满足需求。此时,Selenium库成为解决方案。Selenium可以模拟用户操作浏览器的行为,执行JavaScript代码,从而抓取动态内容。学会使用Selenium,可以大大扩展爬虫的能力范围。

六、数据存储与处理

抓取到的数据需要妥善存储和处理。常见的数据存储方式包括文本文件、CSV文件、数据库等。根据数据量和后续处理需求选择合适的存储方式。同时,掌握基本的数据处理技巧,如数据清洗、去重、格式化等,对于提高数据质量至关重要。

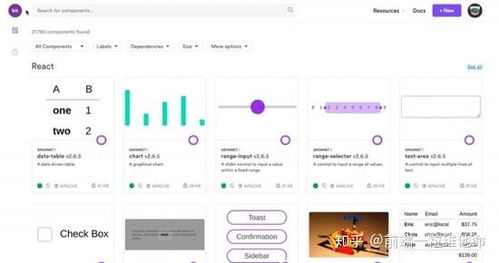

七、实战案例分析

理论学习之后,通过实战案例来巩固知识是非常必要的。可以从简单的静态网页爬取开始,逐步过渡到复杂的动态网页爬取。例如,尝试爬取一个电商网站的商品信息,或者社交媒体上的公开数据。在实战中遇到的问题和挑战,将成为宝贵的学习经验。

八、总结与展望

学习Python爬虫是一个循序渐进的过程,从基础知识到工具使用,再到实战应用,每一步都需要扎实掌握。随着技术的不断发展,爬虫技术也在不断进化,新的框架和工具层出不穷。保持学习的热情和好奇心,紧跟技术潮流,才能在数据时代中立于不败之地。

(随机推荐阅读本站500篇优秀文章点击前往:500篇优秀随机文章)