python爬虫怎样学(如何学习Python爬虫)

Python爬虫是一种通过编程方式自动获取网络信息的技术。学习Python爬虫不仅可以提高数据处理能力,还能为数据分析、市场调研等提供强有力的支持。本文将围绕如何学习Python爬虫展开,从基础知识到实践应用,逐步深入讲解。

首先,我们需要了解什么是Python爬虫。简单来说,爬虫是一种按照特定规则自动抓取互联网信息的程序。Python作为一种简洁高效的编程语言,因其强大的库支持和易读性,成为编写爬虫的首选语言。常见的Python爬虫库包括Requests、BeautifulSoup、Scrapy等。

其次,学习Python爬虫需要掌握一些基础知识。首先是Python基础语法,包括变量、数据类型、控制结构、函数等。这些是编写任何Python程序的基础。其次是HTTP协议的基本概念,理解GET、POST等请求方法以及响应状态码的含义,有助于更好地进行网络请求和处理。

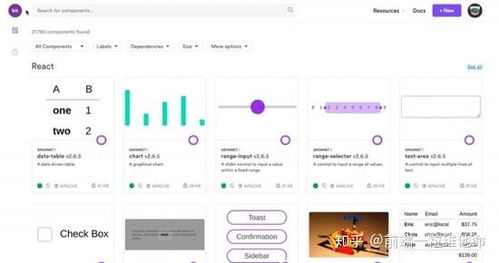

接下来,我们来看一下具体的学习步骤。首先是安装必要的软件和库。Python的安装非常简单,可以从官方网站下载并安装。对于爬虫开发,还需要安装一些常用的第三方库,如Requests用于发送网络请求,BeautifulSoup用于解析HTML文档,Scrapy是一个功能强大的爬虫框架,适合大型项目的开发。

然后是学习网络请求和响应的处理。使用Requests库可以方便地发送HTTP请求并获取响应内容。例如,使用requests.get()方法可以获取网页内容,response.text可以获取响应的文本内容。通过解析HTML文档,可以提取所需的数据。BeautifulSoup是一个非常流行的HTML解析库,可以轻松地查找和提取网页中的元素。

在掌握了基本的请求和解析技术后,可以开始学习如何使用Scrapy框架进行爬虫开发。Scrapy是一个为了爬取网站数据、提取结构性数据而编写的应用框架,具有异步处理、自动处理请求和响应等功能。通过定义Spider类,可以实现自定义的爬虫逻辑,如起始URL、解析规则、数据存储等。

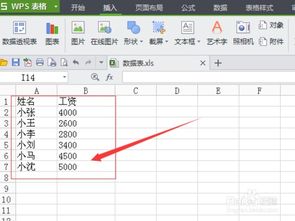

此外,学习Python爬虫还需要注意一些实际问题。首先是遵守网站的robots.txt文件,尊重网站的爬取规则。其次是处理反爬机制,如IP封锁、动态加载内容等。可以使用代理IP、模拟浏览器行为等方式来规避这些限制。最后是数据的存储和管理,根据需求选择合适的存储方式,如CSV、JSON、数据库等。

综上所述,学习Python爬虫需要从基础知识入手,逐步掌握网络请求、HTML解析、爬虫框架的使用等技能。同时,还需注意遵守法律和道德规范,合理使用爬虫技术。通过不断实践和积累经验,可以成为一名优秀的爬虫工程师。

文章大纲:

1.引言:

简要介绍Python爬虫的概念和重要性。

2.Python爬虫基础知识:

解释什么是Python爬虫及其常用库。

3.学习步骤:

详细介绍学习Python爬虫的具体步骤和方法。

4.Scrapy框架:

讲解如何使用Scrapy框架进行爬虫开发。

5.注意事项:

讨论在实际爬虫开发中需要注意的问题。

6.总结:

总结学习Python爬虫的重要性和学习方法。

(随机推荐阅读本站500篇优秀文章点击前往:500篇优秀随机文章)