python爬虫需要学哪些东西(Python爬虫学习要点)

Python爬虫是一种通过编程方式自动获取互联网信息的技术。随着大数据和人工智能的发展,Python爬虫在数据收集、数据分析和网络监控等领域得到了广泛应用。学习Python爬虫需要掌握多方面的知识和技能,包括编程语言基础、网络协议、HTTP请求处理、网页解析技术、数据存储以及反爬策略等。本文将详细阐述这些内容,帮助读者系统地了解和学习Python爬虫所需的知识。

文章大纲:

1.Python语言基础

2.HTTP协议与请求处理

3.网页解析技术

4.数据存储与管理

5.反爬策略与应对

6.实战项目与经验分享

7.总结

1.Python语言基础

Python是一门易学易用的高级编程语言,是进行爬虫开发的首选语言之一。首先,学习Python的基本语法和数据结构,如变量、列表、字典、条件语句和循环等。其次,熟悉Python的标准库和常用模块,如os、sys、datetime等。此外,还需要掌握面向对象编程(OOP)的概念,因为很多爬虫框架都是基于OOP设计的。例如,使用类和对象来组织和管理爬虫代码,可以提高代码的可读性和可维护性。

2.HTTP协议与请求处理

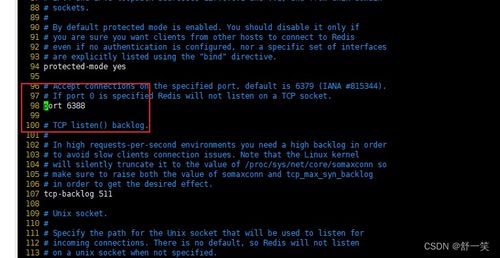

了解HTTP协议的基本原理是编写爬虫的基础。HTTP协议定义了客户端和服务器之间的通信规则,包括请求方法(GET、POST等)、请求头、响应状态码等。Python中常用的HTTP请求库有urllib、requests等。requests库因其简单易用而广受欢迎,可以方便地发送GET、POST请求,处理Cookies、会话等。例如,使用requests库可以轻松模拟浏览器行为,发送带有自定义头部的请求,从而绕过一些简单的防爬机制。

3.网页解析技术

网页解析是将HTML页面转换为结构化数据的过程。Python中常用的网页解析库有BeautifulSoup、lxml和pyquery等。BeautifulSoup适用于处理复杂的HTML文档,支持多种解析器,如lxml、html.parser等。lxml则是一个功能强大且高效的XML和HTML解析库,支持XPath和XSLT。例如,使用BeautifulSoup可以从HTML文档中提取特定的标签和属性,从而实现数据的精确抓取。

4.数据存储与管理

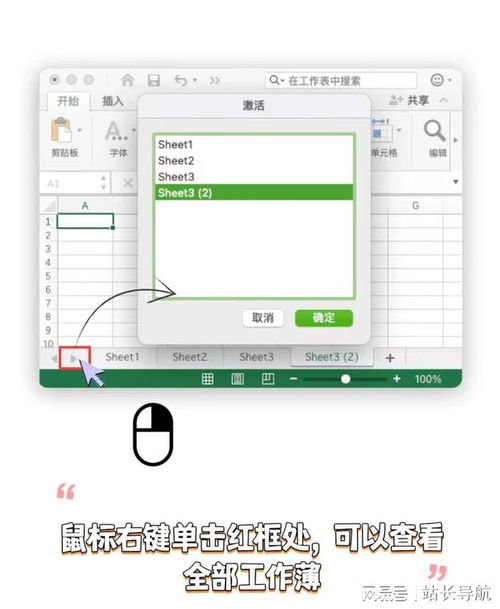

抓取到的数据需要进行存储和管理,以便后续分析和处理。Python提供了多种数据存储方式,包括文件存储(如CSV、JSON、Excel)、数据库存储(如MySQL、MongoDB、SQLite)等。对于小规模数据,可以使用CSV或JSON格式进行存储;对于大规模数据,建议使用数据库进行存储和管理。例如,使用pandas库可以方便地将数据保存为CSV文件,而使用pymysql或pymongo库可以连接MySQL或MongoDB数据库,实现数据的持久化存储。

5.反爬策略与应对

为了防止爬虫对服务器造成过大压力或抓取敏感信息,网站通常会采取各种反爬措施,如IP封锁、验证码、动态加载内容等。了解常见的反爬策略并制定相应的应对方案是爬虫开发者必备的技能。常见的反爬应对措施包括使用代理IP、设置请求间隔、模拟浏览器行为、处理验证码等。例如,使用selenium库可以模拟真实的浏览器操作,从而绕过一些简单的反爬机制。

6.实战项目与经验分享

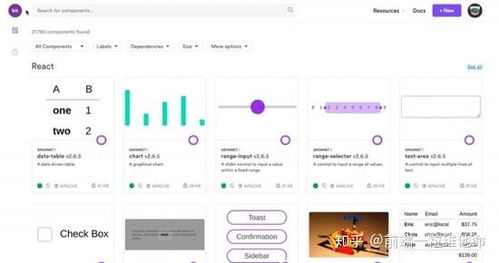

理论知识的学习最终要落实到实际项目中。通过参与实际的爬虫项目,可以积累丰富的经验和技巧。可以选择一些开源的爬虫项目进行学习和模仿,如Scrapy、PySpider等。此外,还可以尝试自己设计和实现一个完整的爬虫项目,从需求分析、数据抓取、数据处理到结果展示,全面锻炼自己的能力。例如,爬取电商网站的商品信息、社交媒体的用户数据等,都是很好的练手项目。

7.总结

学习Python爬虫需要掌握多方面的知识和技能,包括Python语言基础、HTTP协议与请求处理、网页解析技术、数据存储与管理、反爬策略与应对等。通过系统的学习和实践,可以逐步提高自己的爬虫开发能力。同时,参与实际项目和社区交流也是提升技能的重要途径。希望本文能为初学者提供一个清晰的学习路线图,帮助他们更好地入门和进阶Python爬虫开发。

(随机推荐阅读本站500篇优秀文章点击前往:500篇优秀随机文章)