从零开始学python网络爬虫(零起点Python爬虫入门)

Python网络爬虫是一种自动化程序,用于从互联网上提取数据。对于初学者来说,学习Python网络爬虫可能会感到有些困难,但通过系统的学习和实践,任何人都可以从零开始掌握这项技术。本文将围绕“从零开始学Python网络爬虫”这一主题,详细介绍如何入门、进阶和实际应用。

文章大纲

一、引言

二、Python基础知识回顾

三、安装必要的库和工具

四、HTTP协议基础

五、编写第一个简单爬虫

六、处理网页内容

七、数据存储与管理

八、高级特性与优化

九、实战案例分析- 十、总结与展望

一、引言

网络爬虫是一种自动化工具,用于从互联网上收集数据。Python因其简洁的语法和丰富的第三方库,成为编写网络爬虫的首选语言。本文将带领读者从零开始学习Python网络爬虫,涵盖基础知识、工具安装、基本操作以及高级技巧等内容。

二、Python基础知识回顾

在深入学习网络爬虫之前,有必要回顾一下Python的基础知识,包括变量、数据类型、控制结构、函数和模块等。这些知识是编写任何Python程序的基础。

三、安装必要的库和工具

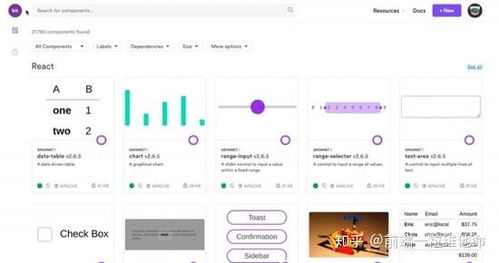

为了编写网络爬虫,我们需要安装一些必要的库和工具,如requests、BeautifulSoup、lxml等。这些库可以帮助我们发送HTTP请求、解析HTML文档和处理XML数据。此外,还需要安装一个文本编辑器(如PyCharm)和一个虚拟环境管理工具(如venv)。

四、HTTP协议基础

HTTP(HyperText Transfer Protocol)是互联网上应用最为广泛的一种网络协议。了解HTTP协议的基本概念和工作原理,对于编写网络爬虫至关重要。本节将介绍HTTP请求方法、状态码、头部信息等内容。

五、编写第一个简单爬虫

通过一个简单的示例,展示如何使用Python编写一个基本的Web爬虫。这个爬虫将向目标网站发送HTTP请求,获取网页内容并打印出来。

六、处理网页内容

获取到网页内容后,我们需要对其进行解析,提取有用的信息。本节将介绍如何使用BeautifulSoup和lxml等库来解析HTML文档,提取所需的数据。

七、数据存储与管理

提取到的数据需要进行存储和管理。本节将介绍如何使用数据库(如MySQL、MongoDB)和文件系统来存储爬虫获取的数据。

八、高级特性与优化

为了提高爬虫的效率和稳定性,我们可以使用多线程、异步IO等技术对爬虫进行优化。本节还将介绍如何处理反爬机制、模拟登录等高级特性。

九、实战案例分析

通过一个实际的项目案例,展示如何综合运用所学知识,完成一个完整的网络爬虫项目。这个案例将涵盖需求分析、设计思路、代码实现和测试等环节。

十、总结与展望

本文详细介绍了从零开始学习Python网络爬虫的过程,包括基础知识回顾、工具安装、HTTP协议基础、编写简单爬虫、处理网页内容、数据存储与管理、高级特性与优化以及实战案例分析等方面的内容。希望读者通过本文的学习,能够掌握Python网络爬虫的基本技能,为进一步的研究和应用打下坚实的基础。

未来,随着互联网技术的不断发展,网络爬虫将面临更多的挑战和机遇。作为开发者,我们需要不断学习和探索新的技术和方法,以应对不断变化的网络环境。同时,我们也要遵守法律法规和道德规范,合理使用网络爬虫技术,为社会创造价值。

(随机推荐阅读本站500篇优秀文章点击前往:500篇优秀随机文章)