python爬虫要学什么(学Python爬虫需掌握哪些技能)

Python爬虫是一种自动化工具,用于从互联网上抓取数据。它广泛应用于数据分析、市场研究、舆情监控等领域。要掌握Python爬虫技能,需要学习多个方面的知识。本文将围绕关键词“python爬虫要学什么”,详细阐述需要掌握的内容。

首先,我们需要了解Python爬虫的基本概念和原理。爬虫是一种模拟浏览器行为的程序,通过发送HTTP请求获取网页内容,然后解析这些内容以提取所需的数据。Python作为一种高级编程语言,具有简洁易读的语法和丰富的库支持,非常适合编写爬虫程序。

接下来,我们来提炼文章大纲:

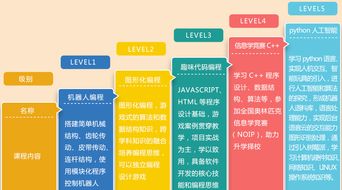

- Python基础语法

- HTTP协议与网络请求

- HTML与CSS基础

- XPath与正则表达式

- BeautifulSoup与lxml解析库

- Scrapy框架

- 数据存储与处理

- 反爬虫策略与应对

一、Python基础语法

在开始学习Python爬虫之前,掌握Python的基础语法是必要的。这包括变量、数据类型、控制结构(如if语句、循环)、函数、类和对象等。此外,还需要熟悉Python的标准库,如os、sys、datetime等。

二、HTTP协议与网络请求

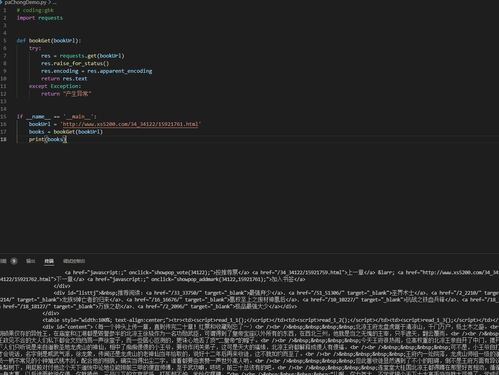

理解HTTP协议是编写爬虫的基础。HTTP(HyperText Transfer Protocol)是互联网上应用最为广泛的一种网络协议。所有的Web页面都是通过HTTP协议传输的。我们需要了解HTTP请求方法(GET、POST等)、状态码、头部信息等。同时,学会使用requests库发送网络请求,获取网页内容。

三、HTML与CSS基础

爬虫的主要任务之一是解析HTML文档。因此,了解HTML和CSS的基础知识是非常重要的。HTML(HyperText Markup Language)是构建网页的标准语言,而CSS(Cascading Style Sheets)用于控制网页的样式。掌握这些知识有助于我们更好地理解和解析网页结构。

四、XPath与正则表达式

XPath是一种在XML文档中查找信息的语言,它可以用于定位HTML元素。正则表达式则是一种强大的文本匹配工具,可以用来匹配复杂的字符串模式。这两种技术在爬虫中都有广泛的应用,特别是在数据提取和清洗过程中。

五、BeautifulSoup与lxml解析库

BeautifulSoup和lxml是Python中最常用的两个HTML解析库。BeautifulSoup提供了简单易用的API来解析HTML文档,并提取所需的数据。lxml则是一个功能强大且高效的XML处理库,支持XPath查询。这两个库可以帮助我们快速构建爬虫程序。

六、Scrapy框架

Scrapy是一个为了爬取网站数据、提取结构性数据而编写的应用框架。它是异步的爬虫框架,可以高效地处理大量请求。Scrapy提供了一套完整的解决方案,包括爬虫的创建、数据的提取、存储以及日志记录等。学习Scrapy可以大大提高我们的开发效率。

七、数据存储与处理

爬虫抓取的数据通常需要进行存储和处理。常见的存储方式有文本文件(如CSV、JSON)、数据库(如MySQL、MongoDB)等。此外,我们还可以使用Pandas等数据处理库对数据进行清洗、转换和分析。

八、反爬虫策略与应对

随着爬虫技术的发展,越来越多的网站采取了反爬虫措施来保护自己的数据。常见的反爬虫策略有IP封锁、验证码、动态加载等。为了应对这些挑战,我们需要学习一些技巧和方法,如使用代理IP、模拟浏览器行为、破解验证码等。

总之,要成为一名合格的Python爬虫工程师,我们需要掌握多方面的知识和技能。从Python基础语法到HTTP协议、HTML解析、数据存储与处理、反爬虫策略等,都需要我们不断学习和实践。只有通过不断地积累经验和提高技能,才能在这个领域取得更好的成绩。

(随机推荐阅读本站500篇优秀文章点击前往:500篇优秀随机文章)