0基础学python爬虫教程(Python爬虫入门教程)

0基础学Python爬虫教程

总述

Python爬虫是利用编程技术自动获取网络数据的一种手段。通过模拟浏览器的行为,爬虫可以抓取网页上的各种信息,并将其保存到本地文件或数据库中。本文将详细介绍如何从零开始学习Python爬虫,涵盖基础知识、常用库、实际操作步骤以及常见问题解决方案。无论你是完全没接触过编程的朋友,还是有一定编程基础的初学者,都可以通过本文逐步掌握Python爬虫技术。

大纲

1.基础知识 - Python语法基础 - HTML和CSS基础 - HTTP协议基础

2.常用爬虫库 - Requests库 - BeautifulSoup库

3.简单爬虫示例 - 发送请求获取网页内容 - 解析网页内容 - 提取更多信息

4.爬虫的分类 - 简单爬虫(静态网页) - 动态爬虫(处理JavaScript生成的内容) - 爬虫框架(Scrapy)

5.实战项目与优化 - 实战项目建议 - 代码优化技巧

6.总结 详细阐述

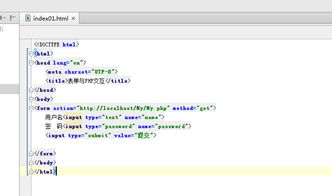

1.基础知识 Python语法基础 Python是一种面向对象的动态类型语言,其简洁的语法非常适合初学者。以下是一些基本的Python语法: - 变量和数据类型:了解如何使用变量存储数据,包括整型、浮点型、字符串等。 - 条件语句:如if、elif和else,用于控制程序的执行流程。 - 循环:如for循环和while循环,用于重复执行代码块。 - 函数:定义和调用函数,提高代码的复用性和可读性。 HTML和CSS基础 HTML(超文本标记语言)是构建网页的标准语言,CSS(层叠样式表)用于控制网页的外观和布局。了解HTML标签、属性和DOM结构,以及CSS选择器和样式规则,对于解析和提取网页内容至关重要。 HTTP协议基础 HTTP(超文本传输协议)是互联网上应用最为广泛的一种网络协议。了解HTTP请求方法(GET、POST等)、状态码、请求头和响应头等基础知识,有助于理解爬虫的工作原理。

2.常用爬虫库 Requests库 Requests是一个用于发送HTTP请求的Python库,使用非常简单。安装Requests库后,可以通过几行代码获取网页内容: ```python import requests response = requests.get('https://www.example.com') print(response.text) ``` 这段代码向指定网址发送GET请求,并打印返回的网页内容。 BeautifulSoup库 BeautifulSoup是一个用于解析HTML和XML文档的Python库。它可以帮助我们从网页内容中提取需要的数据: ```python from bs4 import BeautifulSoup soup = BeautifulSoup(response.text, 'html.parser') title = soup.title.text print('网页标题:', title) ``` 这段代码解析了HTML内容,并提取网页的标题。

3.简单爬虫示例 发送请求获取网页内容 使用Requests库获取网页内容: ```python import requests url = 'https://www.baidu.com' response = requests.get(url) print(response.text) ``` 运行这段代码后,你会看到大量的HTML代码,这就是百度首页的内容。 解析网页内容 使用BeautifulSoup解析网页内容,并提取网页的标题: ```python from bs4 import BeautifulSoup soup = BeautifulSoup(response.text, 'html.parser') title = soup.title.text print('网页标题:', title) ``` 这段代码输出百度首页的标题。 提取更多信息 继续提取网页中的链接: ```python links = soup.find_all('a') for link in links: href = link.get('href') print(href) ``` 这段代码获取网页中的所有链接,并打印每个链接的URL。

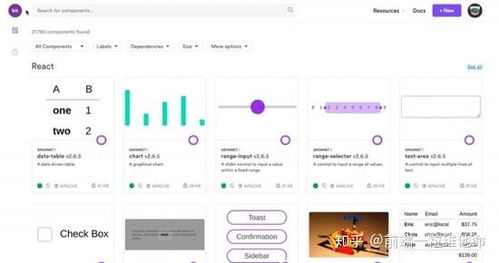

4.爬虫的分类 简单爬虫(静态网页) 如果网页是静态的,所有的数据直接在HTML代码中呈现,这种网页最容易爬取。例如,上述示例中的百度首页就是一个典型的静态网页爬虫。 动态爬虫(处理JavaScript生成的内容) 有些网页的数据不是直接在HTML中呈现,而是通过JavaScript动态生成的。这类网页需要更复杂的处理方式,通常我们会使用Selenium这样的库来模拟浏览器操作: ```python from selenium import webdriver driver = webdriver.Chrome() driver.get('https://www.example.com') print(driver.title) driver.quit() ``` Selenium可以像真实的用户一样与网页交互,甚至可以点击按钮、滚动页面等。 爬虫框架(Scrapy) 当你需要大规模爬取数据时,可以使用专门的爬虫框架——Scrapy。Scrapy是一个强大的爬虫框架,具有异步、高效的特点,适合用于构建复杂的爬虫: ```python import scrapy class ExampleSpider(scrapy.Spider): name = 'example' start_urls = ['https://www.example.com'] def parse(self, response): title = response.css('title::text').get() yield {'title': title} ``` 安装Scrapy后,可以通过简单的配置和代码实现高效的数据爬取。

5.实战项目与优化 实战项目建议 为了更好地掌握Python爬虫技术,可以尝试以下实战项目: - 电商数据爬取:抓取电商平台的商品信息、价格和评论等数据。 - 新闻数据爬取:抓取新闻网站的头条、文章内容和发布时间等数据。 - 社交媒体数据爬取:抓取社交媒体上的用户信息、帖子和互动数据等。 代码优化技巧 在实际开发中,还需要注意以下几点以提高爬虫的效率和稳定性: - 异步编程:使用异步IO提高网络请求的效率。 - 错误处理:添加异常处理机制,确保爬虫在遇到错误时能够继续运行或记录错误信息。 - 去重处理:避免重复抓取相同的数据,浪费资源。 - 代理IP和User-Agent伪装:绕过网站的反爬机制,确保爬虫长时间稳定运行。 总结 本文详细介绍了从零开始学习Python爬虫的过程,包括基础知识的学习、常用爬虫库的使用、实际操作步骤以及常见问题的解决方案。通过系统的学习和不断的实践,相信大家一定能够掌握Python爬虫技术,并在实际应用中取得满意的成果。希望本文对你有所帮助,祝你在学习Python爬虫的道路上取得成功! (随机推荐阅读本站500篇优秀文章点击前往:500篇优秀随机文章)

1.基础知识 - Python语法基础 - HTML和CSS基础 - HTTP协议基础

2.常用爬虫库 - Requests库 - BeautifulSoup库

3.简单爬虫示例 - 发送请求获取网页内容 - 解析网页内容 - 提取更多信息

4.爬虫的分类 - 简单爬虫(静态网页) - 动态爬虫(处理JavaScript生成的内容) - 爬虫框架(Scrapy)

5.实战项目与优化 - 实战项目建议 - 代码优化技巧

6.总结 详细阐述

1.基础知识 Python语法基础 Python是一种面向对象的动态类型语言,其简洁的语法非常适合初学者。以下是一些基本的Python语法: - 变量和数据类型:了解如何使用变量存储数据,包括整型、浮点型、字符串等。 - 条件语句:如if、elif和else,用于控制程序的执行流程。 - 循环:如for循环和while循环,用于重复执行代码块。 - 函数:定义和调用函数,提高代码的复用性和可读性。 HTML和CSS基础 HTML(超文本标记语言)是构建网页的标准语言,CSS(层叠样式表)用于控制网页的外观和布局。了解HTML标签、属性和DOM结构,以及CSS选择器和样式规则,对于解析和提取网页内容至关重要。 HTTP协议基础 HTTP(超文本传输协议)是互联网上应用最为广泛的一种网络协议。了解HTTP请求方法(GET、POST等)、状态码、请求头和响应头等基础知识,有助于理解爬虫的工作原理。

2.常用爬虫库 Requests库 Requests是一个用于发送HTTP请求的Python库,使用非常简单。安装Requests库后,可以通过几行代码获取网页内容: ```python import requests response = requests.get('https://www.example.com') print(response.text) ``` 这段代码向指定网址发送GET请求,并打印返回的网页内容。 BeautifulSoup库 BeautifulSoup是一个用于解析HTML和XML文档的Python库。它可以帮助我们从网页内容中提取需要的数据: ```python from bs4 import BeautifulSoup soup = BeautifulSoup(response.text, 'html.parser') title = soup.title.text print('网页标题:', title) ``` 这段代码解析了HTML内容,并提取网页的标题。

3.简单爬虫示例 发送请求获取网页内容 使用Requests库获取网页内容: ```python import requests url = 'https://www.baidu.com' response = requests.get(url) print(response.text) ``` 运行这段代码后,你会看到大量的HTML代码,这就是百度首页的内容。 解析网页内容 使用BeautifulSoup解析网页内容,并提取网页的标题: ```python from bs4 import BeautifulSoup soup = BeautifulSoup(response.text, 'html.parser') title = soup.title.text print('网页标题:', title) ``` 这段代码输出百度首页的标题。 提取更多信息 继续提取网页中的链接: ```python links = soup.find_all('a') for link in links: href = link.get('href') print(href) ``` 这段代码获取网页中的所有链接,并打印每个链接的URL。

4.爬虫的分类 简单爬虫(静态网页) 如果网页是静态的,所有的数据直接在HTML代码中呈现,这种网页最容易爬取。例如,上述示例中的百度首页就是一个典型的静态网页爬虫。 动态爬虫(处理JavaScript生成的内容) 有些网页的数据不是直接在HTML中呈现,而是通过JavaScript动态生成的。这类网页需要更复杂的处理方式,通常我们会使用Selenium这样的库来模拟浏览器操作: ```python from selenium import webdriver driver = webdriver.Chrome() driver.get('https://www.example.com') print(driver.title) driver.quit() ``` Selenium可以像真实的用户一样与网页交互,甚至可以点击按钮、滚动页面等。 爬虫框架(Scrapy) 当你需要大规模爬取数据时,可以使用专门的爬虫框架——Scrapy。Scrapy是一个强大的爬虫框架,具有异步、高效的特点,适合用于构建复杂的爬虫: ```python import scrapy class ExampleSpider(scrapy.Spider): name = 'example' start_urls = ['https://www.example.com'] def parse(self, response): title = response.css('title::text').get() yield {'title': title} ``` 安装Scrapy后,可以通过简单的配置和代码实现高效的数据爬取。

5.实战项目与优化 实战项目建议 为了更好地掌握Python爬虫技术,可以尝试以下实战项目: - 电商数据爬取:抓取电商平台的商品信息、价格和评论等数据。 - 新闻数据爬取:抓取新闻网站的头条、文章内容和发布时间等数据。 - 社交媒体数据爬取:抓取社交媒体上的用户信息、帖子和互动数据等。 代码优化技巧 在实际开发中,还需要注意以下几点以提高爬虫的效率和稳定性: - 异步编程:使用异步IO提高网络请求的效率。 - 错误处理:添加异常处理机制,确保爬虫在遇到错误时能够继续运行或记录错误信息。 - 去重处理:避免重复抓取相同的数据,浪费资源。 - 代理IP和User-Agent伪装:绕过网站的反爬机制,确保爬虫长时间稳定运行。 总结 本文详细介绍了从零开始学习Python爬虫的过程,包括基础知识的学习、常用爬虫库的使用、实际操作步骤以及常见问题的解决方案。通过系统的学习和不断的实践,相信大家一定能够掌握Python爬虫技术,并在实际应用中取得满意的成果。希望本文对你有所帮助,祝你在学习Python爬虫的道路上取得成功! (随机推荐阅读本站500篇优秀文章点击前往:500篇优秀随机文章)

来源:本文由易搜IT博客原创撰写,欢迎分享本文,转载请保留出处和链接!