python爬虫需要学什么(学Python爬虫需掌握哪些技能)

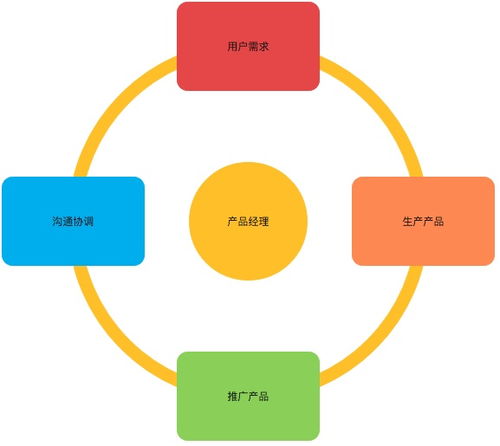

Python爬虫作为一种自动化获取网页数据的工具,近年来在数据分析、信息收集和网络监控等领域得到了广泛应用。对于初学者来说,了解并掌握Python爬虫的相关知识显得尤为重要。本文将详细阐述学习Python爬虫需要掌握的主要内容,帮助读者系统地学习和掌握这一技能。

首先,我们需要明确学习Python爬虫的总体目标。Python爬虫的学习可以分为几个关键部分:基础知识、HTTP协议理解、网页解析、数据存储以及高级技巧。这些内容构成了一个完整的学习体系,帮助我们从入门到精通逐步掌握Python爬虫技术。

接下来,我们来提炼文章大纲,以便更好地组织和阐述各个要点。

文章大纲:

- 基础知识

- HTTP协议理解

- 网页解析

- 数据存储

- 高级技巧

一、基础知识

学习Python爬虫的第一步是掌握Python编程的基础知识。这包括变量、数据类型、控制结构(如循环和条件语句)、函数、模块和包等基本概念。此外,还需要熟悉Python的标准库,特别是与文件操作、字符串处理和异常处理相关的模块。这些基础知识是编写爬虫程序的基础,只有掌握了这些内容,才能顺利进行后续的学习。

二、HTTP协议理解

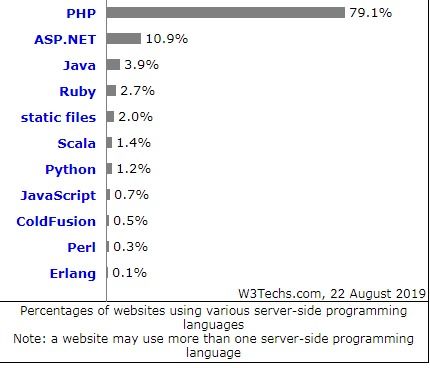

HTTP协议是互联网上应用最为广泛的一种网络协议,所有的Web页面和服务都是通过HTTP协议来进行传输的。因此,理解HTTP协议对于编写爬虫程序至关重要。我们需要了解HTTP请求的基本组成,包括请求行、请求头和请求体;同时,还需要了解HTTP响应的结构,包括状态行、响应头和响应体。此外,还需要掌握常见的HTTP状态码及其含义,如200表示成功,404表示未找到等。通过理解HTTP协议,我们可以更好地模拟浏览器行为,从而编写出更加高效和稳定的爬虫程序。

三、网页解析

网页解析是爬虫程序的核心功能之一,它负责从HTML文档中提取出我们需要的数据。为了实现这一功能,我们需要学习HTML和CSS的基础知识,了解网页的结构和元素的布局方式。同时,还需要掌握一种或多种网页解析库的使用,如BeautifulSoup、lxml等。这些库提供了丰富的API,可以帮助我们方便地查找和提取网页中的元素。例如,使用BeautifulSoup库,我们可以通过标签名、类名或ID等方式查找元素,并获取其文本内容或属性值。通过学习网页解析技术,我们可以从复杂的网页中准确地提取出所需的数据。

四、数据存储

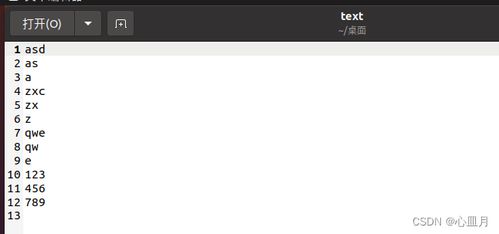

在爬取到数据后,我们需要将其存储起来以便后续的分析和使用。因此,数据存储也是学习Python爬虫的重要内容之一。常见的数据存储方式包括文本文件、数据库和云存储等。对于文本文件存储,我们可以使用Python的文件操作功能,将数据写入到CSV、JSON或TXT等格式的文件中。对于数据库存储,我们需要学习一种关系型数据库(如MySQL、SQLite)和非关系型数据库(如MongoDB)的基本用法,包括数据库的连接、表的创建、数据的插入和查询等操作。对于云存储,则可以了解如何使用云服务提供商(如AWS S

3、Google Cloud Storage)提供的API进行数据的上传和下载。通过学习数据存储技术,我们可以将爬取到的数据持久化保存,并方便地进行后续的处理和分析。

五、高级技巧

当掌握了基础知识和核心技能后,我们可以尝试学习一些高级技巧来提升爬虫程序的性能和稳定性。这些高级技巧包括异步IO、代理设置、验证码识别和反爬虫策略等。异步IO可以提高爬虫程序的并发性能,使其能够同时处理多个请求;代理设置可以解决IP被封禁的问题,提高爬虫程序的稳定性;验证码识别可以应对一些网站的反爬虫机制,使我们能够顺利地爬取数据;反爬虫策略则需要我们了解常见的反爬虫手段,并采取相应的措施来规避这些限制。通过学习这些高级技巧,我们可以编写出更加高效、稳定和智能的爬虫程序。

总结来说,学习Python爬虫需要掌握从基础知识到高级技巧的一系列内容。通过系统的学习和实践,我们可以逐步提升自己的技能水平,并编写出功能强大的爬虫程序来满足各种实际需求。无论是从事数据分析还是网络监控等工作的人员都可以通过学习Python爬虫来提高工作效率和质量。

(随机推荐阅读本站500篇优秀文章点击前往:500篇优秀随机文章)