python学爬虫(学习Python爬虫技巧)

Python学爬虫是一个热门话题,随着互联网数据的爆炸式增长,越来越多的企业和开发者开始关注如何高效地从网络上获取信息。Python因其简洁易学的语法和丰富的第三方库成为学习网络爬虫的首选语言。本文将详细介绍学习Python爬虫的关键点,包括基础知识、常用库、实战案例以及注意事项,帮助初学者系统地掌握这项技能。

文章大纲:

- 基础知识与环境搭建

- 常用爬虫库介绍

- 实战案例分析

- 常见问题及解决方案

- 总结与展望

一、基础知识与环境搭建

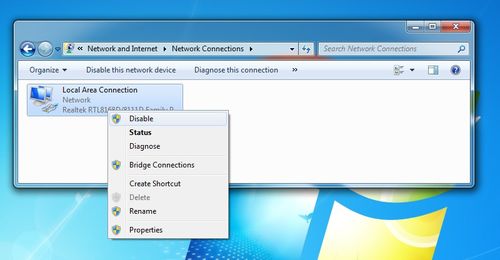

在开始学习Python爬虫之前,首先需要掌握一些基础知识,如HTML/CSS、JavaScript等前端技术的基本概念。这些知识有助于理解网页结构,从而更好地编写爬虫程序。此外,还需要安装Python环境以及相关的开发工具,如PyCharm或Jupyter Notebook,以便进行代码编写和调试。

接下来是安装必要的第三方库。对于Python爬虫来说,最常用的库包括requests(用于发送HTTP请求)、BeautifulSoup(用于解析HTML文档)和lxml(另一种强大的HTML解析库)。通过pip命令可以轻松安装这些库:

pip install requests beautifulsoup4 lxml

掌握这些基础知识和工具后,就可以开始尝试编写简单的爬虫程序了。

二、常用爬虫库介绍

1.Requests:requests是一个非常流行的HTTP库,它简化了HTTP请求的过程。使用requests可以轻松地发送GET或POST请求,并获取响应内容。例如:

import requests

response = requests.get('https://www.example.com')

print(response.text)

这段代码会输出example.com主页的HTML内容。

2.BeautifulSoup:BeautifulSoup是一个用于解析HTML和XML文档的库。它可以帮助我们快速提取网页中的数据。例如:

from bs4 import BeautifulSoup

soup = BeautifulSoup(response.text, 'html.parser')

title = soup.find('title').text

print(title)

这段代码会打印出example.com主页的标题。

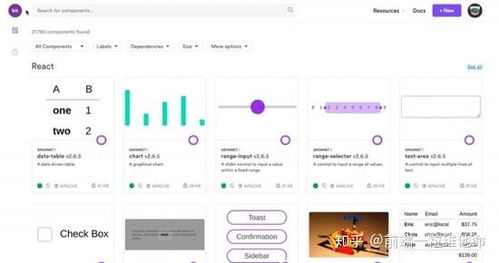

3.Scrapy:Scrapy是一个功能强大的爬虫框架,适用于大型项目。它提供了一整套工具来处理爬取、解析和存储数据。虽然入门门槛较高,但对于复杂任务非常实用。

三、实战案例分析

为了更好地理解Python爬虫的应用,我们来看一个实际的例子——爬取豆瓣电影Top 250的数据。这个案例涵盖了从发送请求到解析数据再到存储结果的整个过程。

首先,我们需要构造一个URL列表,包含所有需要爬取的页面。然后,使用requests库发送请求并获取响应内容。接着,利用BeautifulSoup解析HTML文档,提取所需的信息(如电影名称、评分等)。最后,将数据保存到本地文件或数据库中。以下是一个简单的示例代码:

import requests

from bs4 import BeautifulSoup

url = 'https://movie.douban.com/top250'

headers = {'User-Agent': 'Mozilla/5.0'}

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.text, 'html.parser')

movies = []

for item in soup.find_all('div', class_='item'):

title = item.find('span', class_='title').text

rating = item.find('span', class_='rating_num').text

movies.append({'title': title, 'rating': rating})

for movie in movies:

print(movie)

这段代码会输出豆瓣电影Top 250中的部分电影信息。

四、常见问题及解决方案

在学习和使用Python爬虫的过程中,可能会遇到各种问题。以下是一些常见问题及其解决方案:

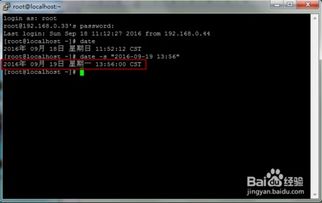

- 反爬机制:许多网站都有反爬机制,如IP封禁、验证码等。解决方法包括使用代理IP、设置合理的请求间隔、模拟浏览器行为等。

- 动态加载内容:有些网站使用JavaScript动态加载内容,传统的requests+BeautifulSoup组合无法直接处理。这时可以使用Selenium等工具模拟浏览器行为,或者分析AJAX请求接口直接获取数据。

- 数据解析错误:在解析复杂HTML结构时,可能会出现解析错误。建议先使用浏览器的开发者工具检查HTML结构,确保选择器正确无误。

- 法律风险:在进行网络爬虫时,务必遵守相关法律法规,不要侵犯他人的版权和隐私权。

通过不断实践和解决问题,可以逐步提高自己的爬虫技术水平。

五、总结与展望

Python爬虫是一项非常实用的技能,广泛应用于数据分析、市场调研、舆情监控等领域。通过本文的介绍,相信大家对Python爬虫有了更深入的了解。未来,随着技术的不断发展,爬虫技术也将更加智能化和高效化。希望本文能为大家的学习之路提供一些帮助和启发。

(随机推荐阅读本站500篇优秀文章点击前往:500篇优秀随机文章)