python爬虫菜鸟教程,python3爬虫菜鸟教程

python爬虫菜鸟教程

学习Python爬虫的菜鸟教程

。Python爬虫是一种强大的网络数据获取工具,对于想要学习网络数据抓取和处理的菜鸟来说,掌握Python爬虫技术是必不可少的。以下是一个适合菜鸟学习Python爬虫的教程。

1. 学习Python基础

。在学习Python爬虫之前,首先要掌握Python的基础知识,包括语法、数据类型、流程控制等。可以通过阅读相关的书籍或在线教程来系统地学习Python的基础知识。

2. 了解网络基础知识

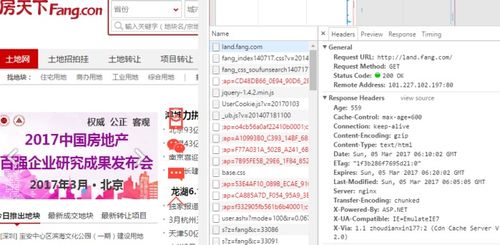

。学习Python爬虫需要对网络原理有一定的了解,包括HTTP协议、网页结构、请求与响应等。可以通过学习相关的网络基础知识来为后续学习打下基础。

3. 掌握爬虫框架

。Python有许多优秀的爬虫框架,如Scrapy、Beautiful Soup、Requests等。菜鸟可以选择其中一个爬虫框架进行学习和实践,掌握其基本用法和常用功能。

4. 学习实战案例

。通过实战案例来学习Python爬虫是最有效的方法之一。可以选择一些简单的网站作为练习对象,尝试编写爬虫程序来抓取网页数据,并对数据进行处理和分析。

5. 持续学习与实践

。学习Python爬虫是一个持续的过程,需要不断地学习新知识、掌握新技术,并通过实践不断提升自己的能力。可以通过阅读相关的书籍、博客文章,参与社区讨论等方式来扩展自己的知识和视野。

结语

。学习Python爬虫需要有耐心和毅力,但只要坚持不懈,相信你一定能够掌握这门技能。希望以上的菜鸟教程能够帮助你入门Pyth。

python3爬虫菜鸟教程

Pytho3爬虫菜鸟教程

什么是爬虫

爬虫是指模拟浏览器行为,自动化地获取互联网上的信息的程序。

爬虫基础

1. 安装Pytho3。

2. 安装爬虫库,如requests、BeautifulSoup等。

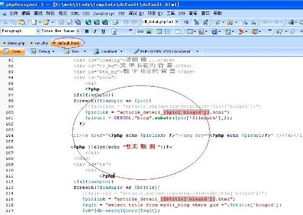

3. 编写爬虫代码,使用requests库发起请求,获取网页内容。

4. 使用BeautifulSoup解析网页内容,提取需要的信息。

爬虫进阶

1. 处理反爬机制,如设置请求头、使用代理等。

2. 学习正则表达式,提取复杂的信息。

3. 学习XPath或CSS选择器,提取HTML中的信息。

4. 学习使用框架,如Scrapy,提高爬虫效率和可维护性。

注意事项

1. 爬虫行为应符合法律法规,不得用于非法用途。

2. 遵守网站的Robots协议,不得对不允许爬取的内容进行爬取。

结语

Pytho3爬虫菜鸟教程希望能帮助初学者快速入门爬虫,了解爬虫的基本原理和常用技术,学会编写简单的爬虫程序。

python 爬虫教程

Pytho 爬虫教程:初学者指南

介绍

爬虫是一种自动化工具,用于从网站提取数据。在 Pytho 中,有许多出色的爬虫库,包括 BeautifulSoup、Requests 和 Seleium。本教程将指导你使用 Pytho 构建你的第一个网络爬虫。

安装 Pytho 爬虫库

要开始使用,你需要安装必要的 Pytho 爬虫库。你可以使用以下命令通过 pip 安装它们:

pip istall beautifulsoup4 requests seleium

使用 BeautifulSoup 解析 HTML

BeautifulSoup一个流行的 Pytho 库,用于解析 HTML 文档。它可以帮助你轻松提取所需的数据。

from bs4 import BeautifulSoup

html_doc = """

欢迎来到我的网站!

这是一个关于 Pytho 爬虫的教程。

"""

soup = BeautifulSoup(html_doc, 'html.parser')

title = soup.fid('title').text

prit(title)

使用 Requests 发送 HTTP 请求

Requests 库可让你轻松向网站发送 HTTP 请求。它提供了获取、发布和更新数据的方法。

import requests

url = 'https://www.example.com'

respose = requests.get(url)

cotet = respose.text

prit(cotet)

使用 Seleium 控制浏览器

Seleium一个强大的 Pytho 库,可让你控制浏览器。它允许你模拟用户交互,例如点击按钮和填写表单。

from seleium import webdriver

driver = webdriver.Chrome()

driver.get('https://www.example.com')

elemet = driver.fid_elemet_by_id('my_elemet')

elemet.click()

总结

本教程提供了 Pytho 爬虫初学者指南。你了解了如何使用 BeautifulSoup 解析 HTML、使用 Requests 发送 HTTP 请求以及使用 Seleium 控制浏览器。使用这些技术,你可以自动化网站的交互并提取所需的数据。

标签:

Pytho

网络爬虫

BeautifulSoup

Requests

Seleium

python爬虫快速入门

Pytho 爬虫快速入门

简介

爬虫是一种脚本或程序,用于自动从网站上提取数据。Pytho用于网络爬虫的强大语言,因为它具有灵活性和易于使用的 Web 爬取库。

安装必要的库

要使用 Pytho 进行爬取,需要安装以下库:

`requests`:用于发送 HTTP 请求

`beautifulsoup4`:用于解析 HTML

`lxml`:用于更快的 HTML 解析(可选)

可以使用 pip 安装这些库:

```

pip istall requests beautifulsoup4 lxml

```

基本爬取

以下是爬取网页的基本步骤:

1. 导入必要的库

2. 使用 `requests.get()` 发送 HTTP GET 请求以获取网页内容

3. 使用 `BeautifulSoup` 解析 HTML 内容

4. 从解析后的内容中提取所需数据

高级爬取技巧

除了基本爬取之外,还有几个高级技巧可以改善爬虫的效率和性能:

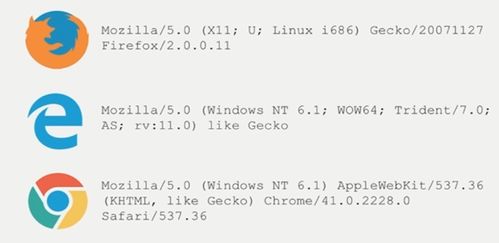

用户代理旋转:定期更改用户代理以避免网站检测

并发请求:使用多线程或多进程进行并发请求

代理使用:使用代理服务器隐藏爬虫的 IP 地址

数据持久化:将提取的数据存储到数据库或文件系统中

应用

Pytho 爬虫可用于各种应用,包括:

网络抓取

数据挖掘

价格比较

实时监控

结论

通过遵循本文中的步骤,您可以快速开始使用 Pytho 进行爬虫。通过掌握高级技巧,您可以创建有效且高效的爬虫,用于各种应用。 (随机推荐阅读本站500篇优秀文章点击前往:500篇优秀随机文章)